Perché l’Industria tarda ad aprire le porte all’AI?

La direzione dell’Intelligenza Artifciale in ambito industriale è già tracciata, ma il tasso di adozione è limitato.

Nello scorso numero abbiamo spiegato perché è improbabile trovare una rete neurale che prenda decisioni operative di alto livello.

Quali sono le altre criticità responsabili della lenta avanzata dell’AI in ambito industriale?

Curva di Apprendimento

Quando una nuova risorsa è inserita nell’organico di un’azienda raggiungerà la piena efficienza dopo un certo periodo di tempo, pari all’estensione della sua curva di apprendimento.

Sebbene la curva di apprendimento sia soggettiva, esistono parametri consolidati che consentono di prevedere con una ragionevole certezza la durata dell’affiancamento e dell’eventuale formazione per ogni lavoratore. Sfortunatamente i dati a disposizione sull’intelligenza artificiale sono ancora lacunosi e tutt’altro che affidabili: questa tecnica si basa infatti su algoritmi diversi applicati in contesti molto eterogenei. Il giudizio non si può basare su “un cervello” e una lista di “mansioni” definite, ma su innumerevoli cervelli artificiali con strutture diverse e un’infinità di compiti da svolgere. L’assenza di informazioni è incertezza. In termini di project management è un rischio, un elemento a sfavore dell’intelligenza artificiale.

È vero che un sistema intelligente imparerà a riconoscere gli scarti di produzione, supponiamo le mele bacate provenienti da un frutteto, ma quante mele dovrà “vedere” prima di raggiungere il livello di un operatore esperto? Quanti errori dovrà fare? Saprà riconoscere anche una mela marcia? Quanto tempo impiegherà ad adattarsi se cambiamo varietà di mele? O se processiamo pere? Non esistono risposte certe. Si possono formulare indicazioni piuttosto accurate sulla base di applicazioni simili, pur sempre con un margine di incertezza.

Quasi sempre il responso finale sulle performance dell’applicazione specifica si può avere solo implementando l’applicazione stessa e verificandola in campo, introducendo un fattore di rischio che richiede una responsabilità di gestione.

Assenza di Buon Senso

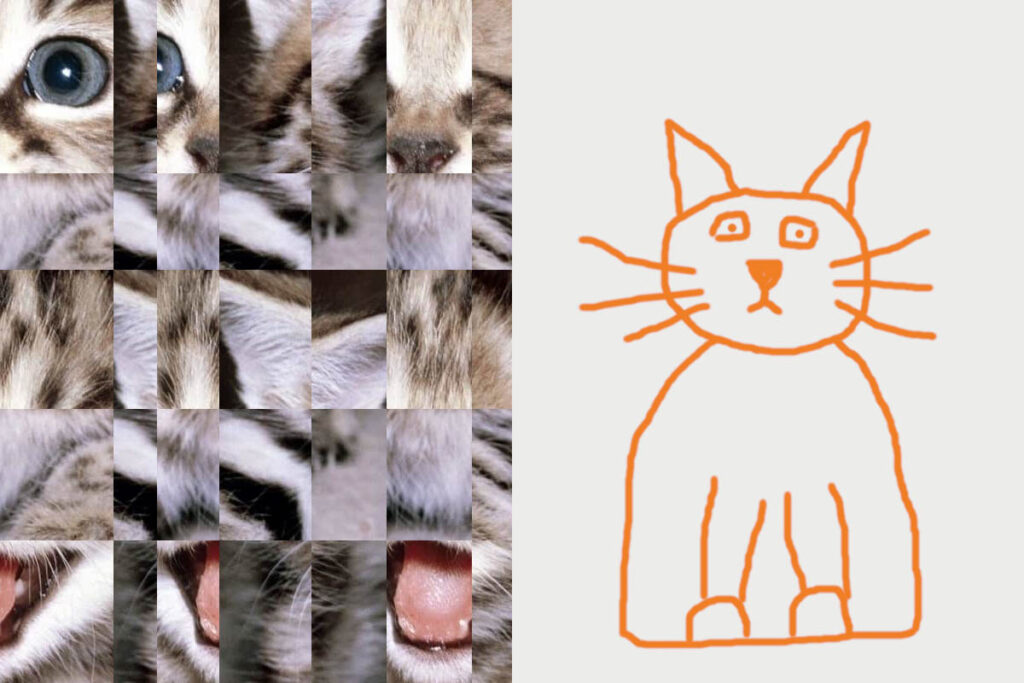

Quando la ricerca si concentrò sulle CNN (Convolutional Neural Network), si palesarono anche i fallimenti di questa tecnica in circostanze apparentemente banali per qualsiasi essere umano. In particolare si dimostrò più volte che una CNN addestrata a riconoscere fotografe di gatti era incapace di riconoscere l’animale se rappresentato sottoforma di fumetto o cartone animato, mentre un’immagine apparentemente priva di senso, costituita da frammenti disordinati di numerose fotografe di gatti, era classificata dalla AI come “gatto” senza margine di dubbio.

Sempre nell’ambito della visione artificiale, sono riportati numerosi esempi di classificazioni palesemente (secondo il giudizio umano) errate di immagini. Un essere umano arriva a prendere decisioni sulla base di più fonti di informazioni, mediate dal contesto, dall’esperienza pregressa e dalla conoscenza sociale. L’elemento più spaventoso dell’intelligenza artificiale è la limitata capacità di contestualizzare le informazioni e di controllare la plausibilità della propria decisione con un comportamento che umanamente definiremmo “Buon Senso”. Potremmo dire che un sistema di questo genere non si renda conto delle conseguenze delle proprie azioni perché di fatto non ha una vera e propria consapevolezza della situazione. Applicare dunque un sistema di AI a un contesto in cui il potenziale danno di una decisione errata è elevato è ancora un tabù per l’ambito industriale che per il momento non può fare a meno del giudizio umano, soprattutto quando la sicurezza può essere compromessa.

Il futuro

L’intelligenza artifciale ha un enorme potenziale e sarà protagonista nella fabbrica del futuro, ma il percorso per una piena difusione è ancora lungo e tutt’altro che scontato.

Come per qualsiasi tecnologia, sarà la standardizzazione a creare un linguaggio comune in grado di mettere in comunicazione i fornitori con gli utilizzatori e gli integratori. In questo senso alcuni passi sono già stati fatti, si pensi alla definizione dei “livelli” della guida autonoma. Sarà necessario poter inquadrare le applicazioni di AI sulla base delle complessità, delle performance e del target di applicazione senza ambiguità e senza margine di incertezza: chi investe in queste applicazioni dovrà sapere oggettivamente cosa compra, come accade per qualsiasi tecnologia presente sul mercato.

Anche i processi di sviluppo e test dovranno trovare la strada giusta per accogliere questa famiglia di tecnologie che spesso richiede criteri di validazione più flessibili e articolati.

Nel frattempo, è importante sfruttarne le potenzialità nei contesti in cui è già ampiamente diffusa (machine vision, speech recognition, consumer behavior…) e mantenere il focus sulla creazione del valore, scegliendo senza pregiudizio il mix tecnologico più adatto all’applicazione.