Quando parliamo di “Data acquisition” stiamo facendo riferimento ad un processo il cui focus primario è quello di entrare in possesso di molte informazioni, i Big data di cui abbiamo tanto sentito parlare da quando è iniziata l’era Industria 4.0.

Oggi poter estrarre grandi moli di dati dai processi e raccoglierli in maniera strutturata rappresenta un’opzione concreta, a patto di utilizzare tecnologie software al passo con i tempi.

I vantaggi di un sistema di data acquisition

I dati di cui parliamo sono informazioni molto dettagliate. Questa conoscenza così profonda di come stiamo performando, la possiamo sfruttare in due modi:

- Monitorare runtime le variabili, innescando in maniera automatizzata «azioni» correlate all’eventuale presenza di OOC (Out Of Control);

- Analizzare una grande mole di dati, utili ad «addestrare» modelli di deep learning, con lo scopo di implementare azioni predittive.

L’organizzazione dei dati: il cuore del sistema

Tutti hanno sempre cercato di “saperne di più” sulle proprie performance, sulla propria efficienza. E su come poter migliorare. Ma i dati grezzi, da soli servono a poco: ci forniscono informazioni poco rilevanti, che non possono fare la differenza. Il plus valore che riesce a darci il dato, lo avremo solo se riusciamo a strutturarlo e ad organizzarlo.

Il processo di data acquisition si svolge secondo un flusso che ha un inizio (una sorgente) ed una fine, la data analysis (reports). Sinteticamente potremmo definire il flusso così:

- Il processo di acquisizione estrapola i dati direttamente dal campo;

- Questi dati grezzi vengono poi collezionati in dataset organizzati, andando a generare moltissimi dati in forma matriciale in grado di auto-incrementarsi continuamente;

- I dataset possono da soli generare delle azioni automatizzate, in presenza di determinati valori che chiameremo OOC (Out Of Control); oppure possono essere combinati con altri dataset acquisiti; possono anche essere utilizzati in complessi modelli matematici per arrivare a definire altre variabili virtuali; infine è possibile mettere in atto dei modelli di deep learning per eseguire calcoli complessi che un modello matematico non riuscirebbe ad eseguire;

- Infine, la fase di data analysis genera report in grado di aiutarci a prendere le decisioni più utili al miglioramento generale del processo.

Cosa fa IMPROVE 4.0

Agenti in missione

IMPROVE 4.0 è il framework di NeXT realizzato utilizzando un paradigma di programmazione molto innovativo: quello ad Agenti, particolarmente adatto per sviluppare algoritmi di Intelligenza Artificiale.

Un Agente è un software che “vive” e persegue un determinato obiettivo. In questo sistema gli agenti coinvolti sono molteplici e seguono diverse missioni: prelevare i dati, ad esempio, da un PLC per renderli “disponibili” per IMPROVE 4.0; fissarne i valori in un determinato istante; confrontarli con quelli impostati in precedenza, in fase di configurazione, con l’obiettivo di rilevare eventuali OOC.

Configurazione delle variabili

In fase di configurazione vengono definiti alcuni parametri di ciascuna variabile: descrizione, dominio, soglie di tolleranza, ecc… Al momento dell’acquisizione, come già detto, gli agenti software andranno a confrontare i valori presenti in IMPROVE con quelli configurati, andando a determinare la presenza o meno di un “fuori controllo”. Il concetto di fuori controllo è fondamentale. È alla base del processo di automatizzazione.

Il fuori controllo diventa un trigger per una serie di possibili azioni/eventi:

- Un feedback verso il processo

- L’invio di una e-mail

- La schedulazione automatica di un in- tervento di manutenzione CBM

- Invio di un messaggio su Telegram

- …

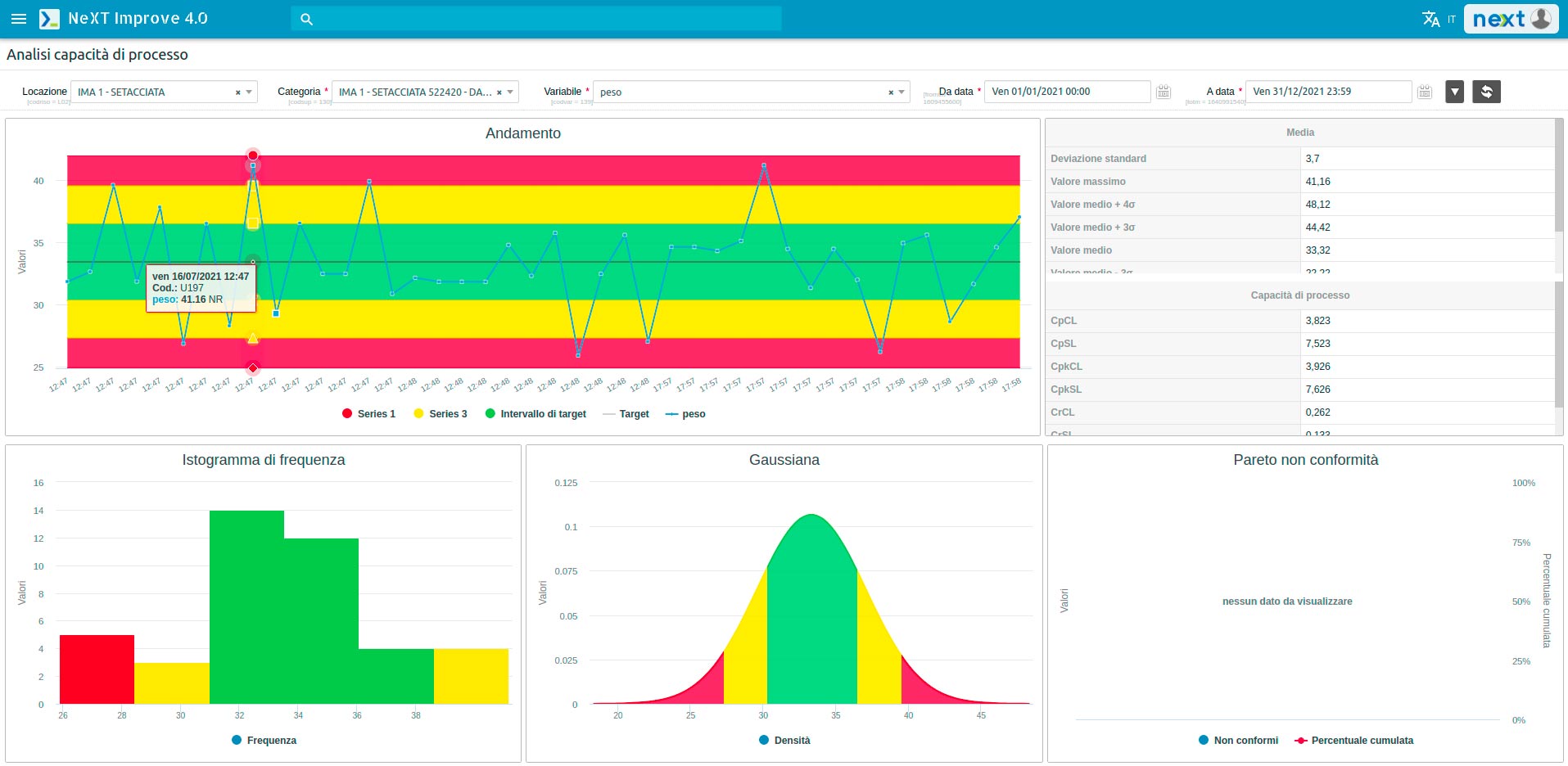

Le soglie di tolleranza sono rappresentate da una diversa colorazione: il colore rosso rappresenta l’area di OOC; il verde e il giallo, le aree con valori accettabili. Altri valori saranno il frutto del collegamento con altri dataset acquisiti attraverso la specificazione di un criterio di aggregazione, oppure di combinazioni con altre variabili attraverso modelli matematici. Infine, è possibile importare modelli di deep learning e svolgere funzioni che sarebbero troppo complesse per un semplice modello matematico.

Data analysis

Una volta acquisiti tutti i dati è possibile passare alla fase di data analysis. I dati vengono strutturati e organizzati in forme tabellari e grafiche. Le tecniche utilizzate derivano direttamente dal controllo statistico di processo:

- Analisi dei trend della variabile

- Analisi statistica

- Analisi della capacità di processo (cp, cpk)

- Istogramma (forma della distribuzione)

- Analisi gaussiana

- Diagramma di Pareto

Un sistema di Data acquisition pone le basi della competitività di domani. I dati necessari per poter estrapolare informazioni davvero utili e strutturate devono essere di grandi dimensioni.

Ci vuole quindi tempo. Per questo è necessario muoversi presto, farlo ora, prima di altri. Le informazioni sono l’oro dell’era che stiamo vivendo. Le informazioni ci parlano e ci indicano.. qual è la cosa giusta da fare.